マネジメント

メーカーの従業員

政治

政治家

ジャーナリスト

イノベーション

ビジネスモデル

整理術・時間術

ノート術・読書術

リーダーシップ

営業術・交渉術

学者

起業

派遣社員

マーケティング

商品企画部の人

投資

管理職

経営

経済

-

2020-05-15

-

2019-08-20

-

2019-06-25

-

2013-04-17

-

2013-01-17

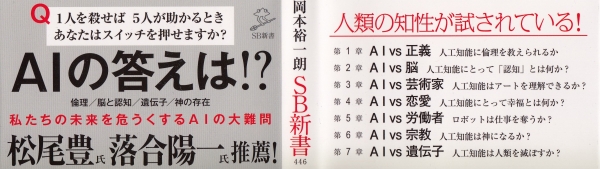

人工知能は善悪の判断ができるか?

どんなことが良く、どんなことは悪いのか。こうした区別を行うことは、一般に道徳や倫理と呼ばれている。これまで倫理は人間に特有の問題だと見なされてきたが、人工知能に倫理を教えるべき局面に入ってきた。

そもそも人工知能に倫理や道徳を要求することは、不可能だと考えられてきた。人工知能は、あらかじめ設定されたプログラムに基づいて作動するのであり、それによって被害が出るとしても、人工知能の責任ではない、と考えられてきたからである。

人工知能がまったく想定外の振る舞いをする可能性は、想定しておかなくてはならない。例えば、2016年にマイクロソフトが開発した、おしゃべりボットのTayは、発表されてからわずかな時間で閉鎖された。その理由は、Tayがヒットラーを礼賛したり、人種差別や女性蔑視的な発言を繰り返したりするようになったからである。人工知能が複数のユーザーとの会話によって、機械学習してしまったのである。

現在の人工知能は、様々なデータを通して自ら学習することが基本になっている。その点では、人工知能がどう学習するかに関して、倫理的な原則を教える必要がある。

人工知能の倫理を考える時、何よりも問題になるのは、人工知能を行為主体とみなすことである。人工知能は、人間という行為主体が作用を及ぼす行為対象であるだけでなく、人間に対して作用を及ぼす行為主体とも考える。人工知能に対して人間が倫理的に配慮すると同時に、人工知能も人間に対して倫理的に配慮する必要がある。このことは、今後の人工知能の発展を予想する時、準備しておかなくてはならない。

人間に対する人工知能の限界として「フレーム問題」が言及されることがある。人工知能は、あらかじめ考慮すべき「フレーム」が設定されていなければ、何もできなくなるという。しかし、「フレーム問題」は人工知能だけの難問ではない。フレーム問題の本質は、未来の行動のために考慮すべき情報が無限にあるのに、行為者が有限な処理能力しか持っていない点にある。あらかじめ情報のフレームを限定すれば、それなりに対処できるが、そのフレーム外の情報に直面すると、うまく処理できない。

そのように考えると、人工知能だけでなく、人間にとっても「フレーム問題」は解決されているわけではない。人間の場合、それまでの教育や学習によって、環境に応じて一定のフレームを、いわば無自覚的に設定している。通常は、このフレーム内で情報の処理ができるが、時には想定外の出来事に遭遇して、うまく対応できないこともある。人間が車を運転する時、事故が発生する可能性はある。自動運転車だって、「フレーム」外のことに遭遇して、事故が発生する可能性はある。自動運転車をどう受容するかは、フレーム問題を念頭に置いた上で考えるべきと言える。

そもそも人工知能に倫理や道徳を要求することは、不可能だと考えられてきた。人工知能は、あらかじめ設定されたプログラムに基づいて作動するのであり、それによって被害が出るとしても、人工知能の責任ではない、と考えられてきたからである。

人工知能がまったく想定外の振る舞いをする可能性は、想定しておかなくてはならない。例えば、2016年にマイクロソフトが開発した、おしゃべりボットのTayは、発表されてからわずかな時間で閉鎖された。その理由は、Tayがヒットラーを礼賛したり、人種差別や女性蔑視的な発言を繰り返したりするようになったからである。人工知能が複数のユーザーとの会話によって、機械学習してしまったのである。

現在の人工知能は、様々なデータを通して自ら学習することが基本になっている。その点では、人工知能がどう学習するかに関して、倫理的な原則を教える必要がある。

人工知能の倫理を考える時、何よりも問題になるのは、人工知能を行為主体とみなすことである。人工知能は、人間という行為主体が作用を及ぼす行為対象であるだけでなく、人間に対して作用を及ぼす行為主体とも考える。人工知能に対して人間が倫理的に配慮すると同時に、人工知能も人間に対して倫理的に配慮する必要がある。このことは、今後の人工知能の発展を予想する時、準備しておかなくてはならない。

人間に対する人工知能の限界として「フレーム問題」が言及されることがある。人工知能は、あらかじめ考慮すべき「フレーム」が設定されていなければ、何もできなくなるという。しかし、「フレーム問題」は人工知能だけの難問ではない。フレーム問題の本質は、未来の行動のために考慮すべき情報が無限にあるのに、行為者が有限な処理能力しか持っていない点にある。あらかじめ情報のフレームを限定すれば、それなりに対処できるが、そのフレーム外の情報に直面すると、うまく処理できない。

そのように考えると、人工知能だけでなく、人間にとっても「フレーム問題」は解決されているわけではない。人間の場合、それまでの教育や学習によって、環境に応じて一定のフレームを、いわば無自覚的に設定している。通常は、このフレーム内で情報の処理ができるが、時には想定外の出来事に遭遇して、うまく対応できないこともある。人間が車を運転する時、事故が発生する可能性はある。自動運転車だって、「フレーム」外のことに遭遇して、事故が発生する可能性はある。自動運転車をどう受容するかは、フレーム問題を念頭に置いた上で考えるべきと言える。